Maîtriser l’A/B testing permet d’optimiser chaque élément de votre stratégie digitale en s’appuyant sur des données concrètes. En testant différentes versions, vous identifiez celle qui performe le mieux, maximisant ainsi l’engagement et les conversions. Ce processus simple mais puissant s’adapte aussi bien aux débutants qu’aux experts, pour des résultats mesurables et un impact réel sur vos campagnes et projets numériques.

Définir et comprendre l’A/B testing : enjeux et fonctionnement

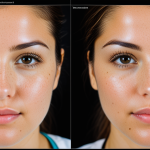

L’A/B testing désigne une méthode statistique permettant de comparer deux versions ou plus d’un élément, dans le but d’analyser l’impact de légers changements sur un objectif défini, comme l’augmentation du taux de conversion ou l’amélioration de l’expérience utilisateur. Si vous décidez d’optimiser avec de l’a/b testing, il devient possible de diviser le trafic en groupes exposés à différentes variantes, mesurant les écarts de résultats en temps réel par le biais d’outils d’analyse comportementale. Les tests A/A servent à valider le protocole, les tests A/B opposent deux variantes, tandis que les tests A/Z ou multivariés évaluent plusieurs alternatives ou combinaisons d’éléments, parfois sur plusieurs pages du parcours utilisateur.

Lire également : Dominer la Stratégie de Contenu B2B : Clés Infaillibles pour Assurer Votre Réussite

Ce processus, au centre des stratégies de data-driven marketing, repose sur :

- Le split des utilisateurs via un algorithme aléatoire,

- Le tracking des interactions (clics, conversions, rebonds),

- L’analyse de la signification statistique grâce à des tests tels que Student ou Welch,

- L’identification des segments d’audience réagissant différemment selon la version testée.

L’A/B testing se révèle essentiel pour chaque entreprise qui souhaite ajuster texte, couleur de bouton ou structure graphique, et ainsi garantir une progression continue de ses indicateurs clés de performance tout en maîtrisant les risques et les coûts d’expérimentation.

Avez-vous vu cela : Les Clés d’une Stratégie SEM Efficace et Gagnante !

Processus étape par étape pour mettre en place un test A/B performant

Audit initial, collecte des données et segmentation de l’audience

La mise en place test efficace commence par un audit détaillé du site, suivi d’une collecte rigoureuse des données disponibles. Il s’agit d’identifier les éléments clés à optimiser selon les indicateurs clés performance, tels que le taux de conversion ou l’optimisation taux clics. La segmentation audience test intervient à cette étape : segmenter visiteurs site selon leur comportement permet d’affiner chaque test split en marketing, multipliant les probabilités d’obtenir des résultats pertinents. La personnalisation parcours client croît ainsi et maximise l’expérience utilisateur améliorée sur chaque segment.

Formulation des hypothèses, définition des objectifs du test

Ensuite, il faut formaliser chaque méthode validation hypothèses : chaque modification proposée s’appuie sur une hypothèse claire, en lien direct avec les enjeux de conversion e-commerce ou l’amélioration landing page. Définir les objectifs test — par exemple, augmenter l’engagement ou réduire le taux abandon panier — oriente la technique comparaison versions et fixe des seuils sur les principaux indicateurs clés performance.

Sélection et utilisation d’outils A/B (plateformes spécialisées, intégration analytics)

Le choix d’outils performants test comme https://www.kameleoon.com/fr/ab-testing est déterminant pour garantir une analyse statistique test robuste et un calcul signification résultats fiable. L’intégration outils analytics permet une interprétation données test précise, facilitant la comparaison métriques conversion et l’ajustement rapide des tests d’hypothèses marketing. Ces solutions outillent chaque phase, du suivi aux recommandations optimisation, pour toute stratégie marketing digital pilotée par le data-driven marketing.

Interpréter les résultats et tirer des enseignements pour l’optimisation continue

Mesure de la performance : KPIs, signification statistique, analyse quantitative et qualitative

La première étape de l’interprétation des données test consiste à évaluer si les résultats obtenus sont statistiquement valides. L’analyse repose sur les indicateurs clés de performance (KPIs) : taux de conversion, taux de clics, et taux de rebond. Pour chaque test, il faut appliquer une analyse statistique rigoureuse afin de distinguer un effet réel d’une simple variance aléatoire. Un résultat n’est considéré comme fiable qu’après confirmation par des statistiques test significatives.

Toutefois, les chiffres bruts de résultats test statistiquement valides ne suffisent pas. Une analyse qualitative résultats vient compléter l’approche quantitative. Elle vise à décrypter les motivations et les freins derrière les comportements observés, par exemple via l’analyse comportement utilisateur et l’étude des sessions utilisateurs.

Priorisation des modifications, validation des hypothèses et intégration des enseignements

Quand les interprétation données test révèlent des écarts notables, il faut prioriser les modifications apportées à l’interface ou au message en privilégiant les tests ayant un impact mesurable sur la conversion. La méthode validation hypothèses implique d’intégrer ces enseignements dans une logique de cycle itératif optimisation, nourrie par des recommandations optimisation concrètes pour l’expérience utilisateur.

Communication des résultats et diffusion de la culture de l’expérimentation en entreprise

Partager une interprétation données test claire facilite la diffusion des apprentissages auprès des équipes. Communiquer sur les statistiques test significatives, sur les analyses comportement utilisateur et sur les recommandations optimisation contribue à installer une culture d’amélioration continue et d’expérimentation au sein de l’entreprise.

Exemples concrets, bonnes pratiques et erreurs à éviter en A/B testing

Cas emblématiques

L’une des illustrations marquantes de l’A/B testing reste la campagne présidentielle d’Obama en 2008. Grâce à des exemples concrets test sur l’optimisation d’emails et de boutons, son équipe a fait passer le taux d’inscription de 8,26% à 11,6%. Cette augmentation taux conversion a généré 288 000 inscriptions supplémentaires, impactant directement le retour sur investissement test. Dans l’e-commerce, des modifications minimes — comme le test couleur bouton ou la formulation des CTA — permettent souvent une optimisation parcours utilisateur et boostent la conversion e-commerce de manière tangible. Les grandes plateformes sociales mettent fréquemment en place une technique comparaison versions pour affiner l’expérience utilisateur améliorée et tester nouvelles fonctionnalités.

Recommandations pour réussir ses tests

Des bonnes pratiques test s’imposent pour fiabiliser vos résultats : un test split en marketing doit durer assez longtemps, avec une segmentation audience test adaptée. Tester de façon incrémentale par l’intermédiaire de test multivarié comparaison affine l’analyse comportement utilisateur. Automatiser la mise en place test, surveiller les indicateurs clés performance et prioriser suivant l’impact optimisation contenu facilitent un cycle itératif optimisation.

Pièges courants

Parmi les erreurs fréquentes test : l’échantillonnage limité fausse le calcul signification résultats, tout comme l’arrêt prématuré du test boutique en ligne. Attention à l’interprétation données test : sur-segmenter, c’est fragiliser la validité statistique. Pour obtenir des résultats test statistiquement valides, structurez clairement chaque démarche et soyez vigilant sur l’analyse quantitative.